| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- 강화학습

- 불확실성

- 텍스트분석

- 리눅스

- 백준

- 베이지안

- AI

- R

- pandas

- selenium

- Crawling

- 파이썬

- 알고리즘

- 빅데이터

- 코딩테스트

- uncertainty

- 논문리뷰

- DATA

- dropout

- Graph

- GNN

- YarinGal

- 데이터분석

- pytorch

- bayesian

- VAE

- PYTHON

- 우분투

- 텍스트마이닝

- 크롤링

- Today

- Total

끄적거림

[논문 리뷰] On Uncertainty, Tempering, and Data Augmentation in Bayesian Classification - 1.Introduction 본문

[논문 리뷰] On Uncertainty, Tempering, and Data Augmentation in Bayesian Classification - 1.Introduction

Signing 2022. 12. 17. 18:38이전 포스팅

[논문 소개] On Uncertainty, Tempering, and Data Augmentation in Bayesian Classification - 0.Abstract

믿음이라는 표현이 나오는데 베이지안이라고 변경해서 해석해도 될듯! 이건 확인이 필요함.

1.1. Epistemic/Aleatoric Uncertainty

Epistemic Uncertainty와 Aleatoric Uncertainty에 대한 설명이 나오지만, 이전 포스팅에서 설명하였으므로 스킵한다.

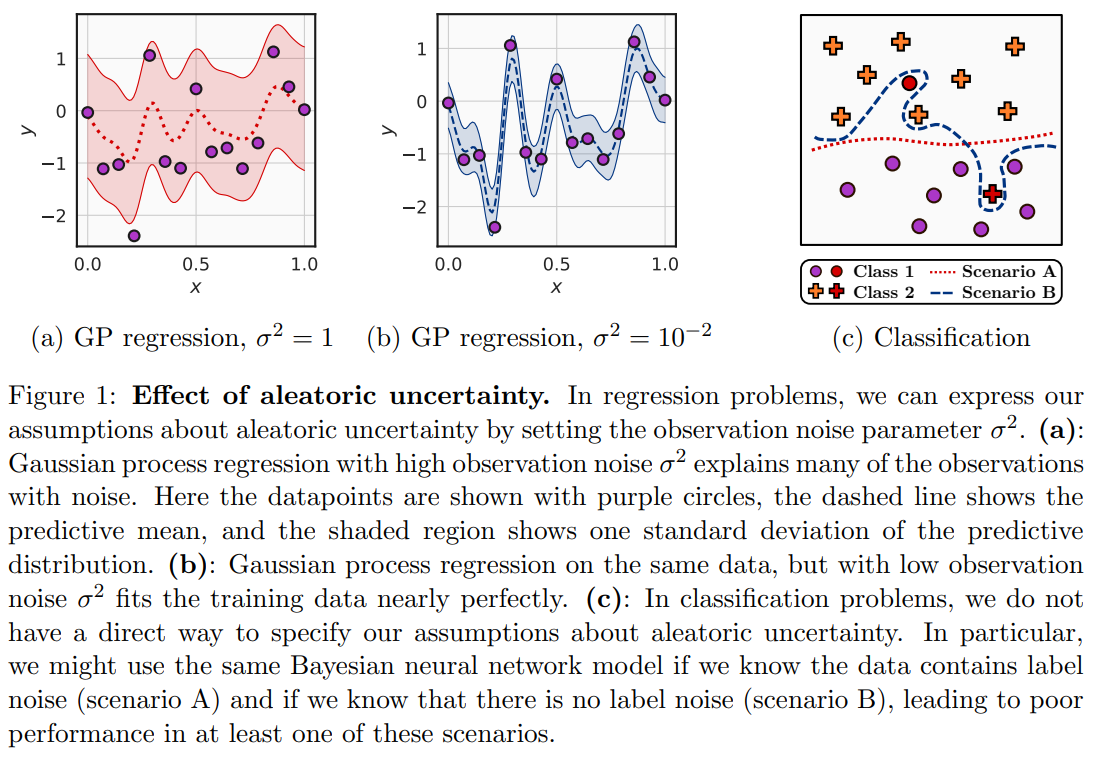

1.2 그림 설명

- 보라색 점은 관측된 데이터이다.

- Gaussian Process Regression(G.P.R.)를 이용해서 모델링 한 것이다.

- (a)는 분산을 1로 높게 설정하여 나타낸 그림이고, 빨간색 점선은 predictive mean, 빨간색 음영된 부분은 predictive distribution의 standard deviation을 나타낸 것이다.

- (b)는 분산을 $10^{-2}$로 매우 낮추어 설정한 그림이고, 파란색 점선은 predictive mean, 파란색 음영된 부분은 predictive distribution의 standard deviation을 나타낸 것이다.

- (c)는 시나리오A와 시나리오B로 classification 문제를 모델링한 그림으로, 원형의 data point와 십자가 data point는 서로 다른 class임을 의미하며, 빨간색 data point들은 잘못 labeling된 data point로 의심하는 상황이다.

Figure1의 (a)와 (b)는 같은 데이터로 같은 RBF kernel을 이용한 G.P.R. 모델을 학습시킨 그림이다.

다른 점은 모델의 분산(noise)을 다르게 적용했다는 점이다.

그에 따라 (a)는 data point들에 fitting되지 않게끔 학습되고, (b)는 거의 fitting하여 학습되었다.

한 편, (c)에 대해 2가지 시나리오를 생각할 수 있다.

첫 번째 시나리오A는 빨간색 data point가 잘못된 labeling(aleatoric uncertainty)되었다고 간주하는 것이다.

그랬을 때, 빨간색 점선대로 classification을 할 수 있다.

다음으로 시나리오B는 빨간색 data point가 올바른 label이라고 간주할 때, 파란색 점선으로 classification할 수 있다.

위 간단한 실험을 통해 알 수 있는 사실은

- 두 가지 solution은 모두 데이터에 대한 합리적인 설명이며, 우리는 Aleatoric Uncertainty에 대한 우리의 가정을 통합해야만 그에 대한 정보에 입각한 선택을 할 수 있다. 시나리오 A/B처럼..

- 회귀 문제에서는 Gaussian likelihood에서 분산 파라미터를 조절해 쉽게 Aleatoric Uncertainty에 대한 가설을 표현할 수 있었지만, 분류 문제에서는 직접적으로 표현할 길이 없다.

- 위에서 봤던 시나리오를 사용했던 것처럼, 분류 문제에서는 여러 시나리오 중 하나를 선택하면 필연적으로 성능 저하가 나타날 수 밖에 없다.

1.3.

본 논문에서, 우리는 분류 문제에서 Aleatoric Uncertainty에 대한 가설 혹은 믿음을 표현하는 방법을 조사하였다.

섹션4에서는 standard softmax likelihood가 predicted class probability에 대한 Dirichlet likelihood와 동등하다는 것을 보여주며, 분류 문제의 Aleatoric Uncertainty에 대해 직접 추론할 수 있는 메커니즘을 제공한다.

이 내용을 기반하여, cold posterior가 Aleatoric Uncertainty에 대한 믿음을 표현하는 자연스러운 방법이라는 것을 보여준다.

제5절에서, 우리는 이론적으로 data augmentation이 어떻게 반직관적으로 likelihood를 부드럽게 하여 훈련 데이터에 맞지 않는 솔루션으로 이어지는지 보여준다.

1.4

요약하면, 우리는 BNN의 분류문제에서 Aleatoric Uncertainty를 명시적으로 특성화하는 것이 어떻게 가능한지, 그리고 베이지안을 이용해 data augmentation을 자연스럽게 수용할 수 있는지 보여준다.

우리는 data augmentation이 likelihood를 부드럽게 하고 CIFAR와 같은 많은 표준 벤치마크는 본질적으로 관찰된 훈련 포인트에 대한 Aleatoric Uncertainty가 없기 때문에 BNN의 cold posterior는 T = 1보다 Aleatoric Uncertainty에 대한 믿음을 더 정직하게 반영한다는 것을 발견했다.

일부 논문은 cold posterior가 BNN 분류기에서 좋은 성능을 제공할 수 있다고 언급하지만, 우리는 cold posterior가 필요하지 않다는 것을 보여준다. - Aleatoric Uncertainty에 대한 우리의 믿음을 반영할 수 있는 likelihood에 대한 간단한 수정은 비슷한 성능을 제공한다.