| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- 우분투

- 텍스트마이닝

- 리눅스

- pytorch

- 알고리즘

- 불확실성

- pandas

- PYTHON

- dropout

- 코딩테스트

- 백준

- 파이썬

- 베이지안

- 데이터분석

- 강화학습

- YarinGal

- 텍스트분석

- AI

- R

- GNN

- bayesian

- 크롤링

- Graph

- 빅데이터

- DATA

- 논문리뷰

- uncertainty

- VAE

- Crawling

- selenium

- Today

- Total

목록데이터분석 (23)

끄적거림

[Databricks] 01. pySpark 시작하기

[Databricks] 01. pySpark 시작하기

pySpark를 공부하고자 VM에 우분투까지 설치했지만, 뭔가 혼자서 책으로 공부하기에 왠지 모를 커다란 장벽이 있는 느낌이었다. 그러다가, edwith에서 제공하는 pySpark 강의가 있기에 그것을 튜토리얼 삼아 공부하기로 했다. 지금부터 시작할 내용은 edwith에서 제공하는 pySpark 강의를 그대로 따라하면서 공부해 나가는 과정을 담을 것이다. edwith: pySpark를 활용한 데이터분석 1. pySpark 환경 선택(Databricks) 기본적으로 본 강의에서는 pySpark를 실행할 수 있는 환경을 Databricks라는 클라우드 플랫폼을 선택했다. Databricks는 유로 클라우드 서비스이지만 무료버전에서도 충분히 사용할 수 있다는 설명이 적혀져 있었다.(test성으로...) Dat..

built-in file 참조하여 활용하기 in PyCharm(feat. API key 관리 및 지역정보 관리)

built-in file 참조하여 활용하기 in PyCharm(feat. API key 관리 및 지역정보 관리)

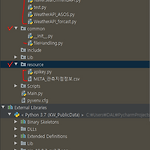

그동안 만들어 놓은 여러 공공데이터 API를 연계한 코드들이 있었다. 그러다 보니 각 API들을 호출할 때마다 요청할 url과 사용자key값들이 다들 제각기고 관리하기 힘들다는 것을 몸소 느꼈다. 또한, 일부 API는 지역코드별로 요청하는 것들도 있기에 csv파일로 된 지역 코드 관리도 필요함을 느꼈다. 이러한 불편함을 줄이고자 resource를 관리할 수 있는 작업을 진행하려 한다. 1. PyCharm 프로젝트 구조 관리 나는 개발 툴로써 pyCharm을 사용했다. 프로젝트 구성은 사진과 같다. 여기서 빨간색 표시한 부분이 새로 만든 하위 폴더(directory) 및 패키지이다. 쉽게 생각하면 eclipse의 package라고 생각하면 되겠다. 먼저, apisrc는 내가 그동안 만든 api연계 코드들을..

[GCP] 데이터 엔지니어링 - 01.프로젝트(project) 만들기

[GCP] 데이터 엔지니어링 - 01.프로젝트(project) 만들기

GCP(Google Cloud Platform)에서는 여러가지 서비스를 제공한다. 그 중 가장 많이 사용하는 것은 클라우드 형태의 DB이다. 기존의 아마존(AWS)이 사실 가장 대표적이고 강력한 클라우드 서비스르 제공하지만 그럼에도 불구하고 GCP를 사용하는 것은 아마도 접근하기 쉽다는 것에 있다. 본 글은 GCP 안에 있는 서비스 중 다음과 같은 순서로 데이터 엔지니어링(여기서 말하는 데이터 엔지니어링은 storage를 만들고 api로 자동으로 storage에 적재한 다음, 이 작업을 스케쥴링하여 자동으로 쌓일 수 있는 과정을 의미한다.)을 작업하려 한다. 01. 프로젝트(project) 만들기 02. 버킷 만들기 03. 스케쥴링 만들기 04. 스토리지(Storage) 만들어 API와 연동하기 05. ..

[Tips] 컴프리헨션(Comprehension), 이터레이터(Iterator), 제너레이터(Generator)

[Tips] 컴프리헨션(Comprehension), 이터레이터(Iterator), 제너레이터(Generator)

R을 많이 사용하던 사람으로써 python의 컴프리헨션(Comprehension), 이터레이터(Iterator), 제너레이터(Generator)와 같은 개념들이 다소 생소했다. 먼저 각 개념부터 알아보자. 컴프리헨션(Comprehension) : 주로 리스트 타입에서 많이 사용하기 때문에 리스트 컴프리헨션이라고도 한다. 반복되는 작업을 간결한 표시로 동작하는 것을 List Comprehension이라고 한다. 예를 보며 확인해보자. # 1. Comprehension a = [x**2 for x in range(5)] print(a) # 2. Normal for loop a = [] for i in range(5): a.append(i**2) print(a) 1번 코드는 컴프리헨션을 이용한 반복 작업이고,..

[API]기상청 api로 데이터 가져오기 in Python(feat. ASOS 종관기상관측)

[API]기상청 api로 데이터 가져오기 in Python(feat. ASOS 종관기상관측)

공공 데이터 중에서 가장 활용도가 높은 기상청 데이터를 사용해볼까한다. 기본적으로 기상청에서는 file(CSV), API(Json, XML) 두 형태로서 데이터를 제공한다. file형태는 원할 때마다 내려 받아서 분석에 활용하면 되지만, 분석에서 만든 모델링을 계속해서 사용하기에는 번거로움이 있다. 따라서 어떤 모델을 구축했다면, API로 데이터를 실시간으로 돌려가며 실시간 모델링을 진행할 수 있다. 그러면, 데이터를 실시간으로 가져올 수 있는 방법인 API에 대해서 알아보자. API란, Application Programming Interface의 약어로, 기기 간 통신을 통하여 데이터나 정보를 주고 받을 수 있는 것이라고 간단히 생각하면 되겠다. 데이터 전송 시, 흔히 많이 쓰이는 자료구조로는 XML..

01. Git Bash 설치 및 저장소(repo) 만들기

01. Git Bash 설치 및 저장소(repo) 만들기

코드 관리나 협업에 사용하기 좋은 Git을 본격적으로 사용해보려 한다. 기존의 깃 활용도는 그닥.. 그냥 로컬에 폴더 만들어서 관리하듯이 repo만들고 거기에 파일 업로드 한 정도.. 하지만, 기회가 생겨 Git을 협업 툴, 코드 형상관리 툴로써 사용해보고자 한다. 일단 기본적으로 여기서 말하는 깃은 Git Bash를 의미하며, Git Bash란 컴퓨터 OS와 상관없이 리눅스 베이스 터미널용 Git을 말한다. 덕분에 리눅스 명령어에 대한 공부도 추가적으로 해주는 것이 좋아보인다. 1. 깃 다운로드 설치 링크 : https://git-scm.com/ Git git-scm.com 위의 설치 링크에 접속하고 download - windows 를 클릭하면 자동으로 내 컴퓨터 환경에 맞게 설치 파일이 다운로드된다..